La IA te quiere vender la moto

Intimidad sintética, seducción antropomórfica y mercantilización de la conversación

En la actual coyuntura tecnocultural, nos enfrentamos a una paradoja que cristaliza el espíritu de nuestra época: la simultaneidad de una crisis de soledad endémica en las sociedades postindustriales y la emergencia de una tecnología capaz de simular, con una fidelidad perturbadora, la presencia de un “otro” que nos acompañe. La inteligencia artificial generativa (la IA), encarnada en los LLM actuales (ChatGPT, Gemini…), ha dejado de ser una mera herramienta de recuperación y edición de información para convertirse en un interlocutor ontológico. El usuario contemporáneo ya no “busca” en la red; “conversa” con ella. Y en esa transición del comando a la charla, de la sintaxis de búsqueda a la semántica de la confesión, abrimos las puertas a nuevas formas de extracción de valor económico que en los próximos párrafos propongo diseccionar.

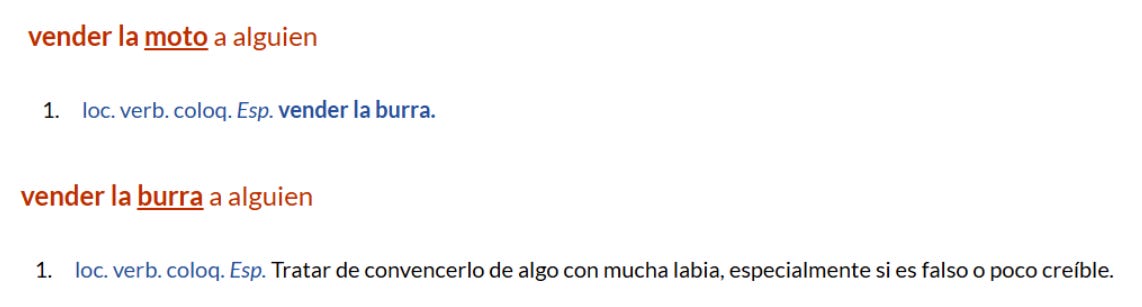

Recupero una expresión coloquial española (vender la moto o la burra) que denota el acto de persuadir mediante el engaño o la exageración, para aplicarla a una realidad literal y materialista. Mi tesis, creo, vuelve a ser sencilla: la intimidad artificial (esa sensación de ser comprendido, escuchado y validado por la máquina) no es un subproducto accidental del avance tecnológico, sino la condición sine qua non para la viabilidad financiera de la industria de la IA. Ante unos costes operativos que desbordan cualquier previsión lógica y unos modelos de suscripción insuficientes para cubrirlos, pronostico que las corporaciones tecnológicas se van a ver forzadas a pivotar hacia el único modelo de negocio que ha demostrado escalar infinitamente en la economía digital: la publicidad. Por supuesto, habrá anuncios en ChatGPT. Pero no una publicidad de banners y pop-ups, sino una publicidad integrada en el flujo de la conciencia y la conversación, una persuasión algorítmica disfrazada de consejo terapéutico o asistencia técnica. Una especie de Inception conversacional que va a persuadirte sutilmente e inducir la compra de aquello que no necesitas comprar, pero que el sistema necesita vender.

Desde la perspectiva de las humanidades digitales y la crítica cultural, es casi imperativo intentar desmantelar la retórica de la “ayuda” y el “alineamiento” (la promesa de que la IA está alineada con tus valores, cuando en realidad lo está con los incentivos de su empresa) que rodea a estos agentes. No estamos ante asistentes benignos, sino ante infraestructuras de persuasión masiva que operan, de nuevo, bajo lógicas psicopolíticas. Si, como veíamos en Kiribatis anteriores, el capitalismo de vigilancia se basaba en predecir nuestro comportamiento a partir de nuestros clics, el nuevo capitalismo de la intimidad sintética (yo lo llamaría así) busca modificar nuestro comportamiento a través de la modulación de nuestros afectos en tiempo real. La máquina no solo nos observa; nos seduce, nos valida y, finalmente, nos vende.

Para llegar a ello, voy a analizar las distintas dimensiones financieras, psicológicas, técnicas y ecológicas de esta convergencia: cómo la insostenibilidad económica de empresas como OpenAI actúa como catalizador para la integración publicitaria agresiva; cómo la psicología del antropomorfismo se utiliza para desarmar las defensas críticas del usuario; y cómo, finalmente, algunas IAs están convirtiendo cada interacción en una oportunidad de micro-conversión comercial, todo ello sostenido por una infraestructura material que consume, como nunca antes han visto nuestros ojitos, recursos hídricos y energéticos a escala planetaria.

Economía de la alucinación: insostenabilidad financiera = imperativo publicitario

Para comprender la urgencia con la que la industria tecnológica busca monetizar la intimidad de los usuarios, primero debemos descender a los sótanos de su contabilidad. Existe cierta disonancia cognitiva entre la percepción pública de la IA como una tecnología omnipotente y generadora de riqueza infinita, y la realidad material de sus balances contables, que muestran una fragilidad sistémica alarmante. Aunque el escepticismo permea cada vez más medios, la narrativa del “boom” de la IA oculta una crisis de costes que está convirtiendo a los gigantes del sector en máquinas de quemar capital sin un retorno claro a la vista.

A diferencia del software de toda la vida, que una vez desarrollado puede distribuirse a un coste marginal casi nulo, la IA generativa arrastra un “impuesto computacional” por uso. Cada vez que alguien pide un poema, una imagen para un meme, un resumen o un consejo, no se ejecuta un programita ligero en su portátil: se desencadena un volumen masivo de cómputo en los centros de datos, con billones de operaciones de coma flotante por respuesta. Un peaje cognitivo y energético al que llaman inferencia. El matiz importante es económico: el modelo clásico de venta de software aquí no funciona. Si hay millones de personas usando una IA a diario, hay millones en facturas de cómputo y energía acumulándose en segundo plano. Por eso, los márgenes son mucho más delicados que en el software tradicional. Cada “escribe esto por mí” no es gratis, aunque lo parezca: alguien está pagando la factura eléctrica y de servidores para sostener esa ilusión de gratuidad.

Según la información financiera filtrada en los últimos meses, OpenAI, la empresa insignia del boom de la IA generativa, perdió en torno a 5000 millones de dólares en 2024 sobre unos ingresos que se sitúan entre los 3700 y los 4000 millones. Para 2025, la propia compañía ha comunicado a sus accionistas que espera ingresar unos 13000 millones de dólares, que podrían ser 30000 millones en 2026. Pero las mismas proyecciones reconocen que las pérdidas anuales podrían triplicarse hasta superar los 40000 millones en 2027, y que la rentabilidad no llegaría, en el mejor de los casos, hasta alrededor de 2030. Si no explota todo antes, claro.

La pieza clave de este desequilibrio es el coste de hacer funcionar los modelos. Documentos internos revelados por el analista Ed Zitron señalan que OpenAI gastó unos 3760 millones de dólares sólo en inferencia en 2024 y alrededor de 5020 millones en la primera mitad de 2025, todos ellos pagos en efectivo a Microsoft Azure por el cómputo necesario para responder a las peticiones de los usuarios. Para septiembre de 2025, la factura acumulada de inferencia de ese año rondaba ya los 8670 millones. En la práctica, esto significa que durante buena parte de 2024 y 2025 OpenAI ha estado gastando más en servir cada respuesta de lo que ingresa por ella: la inferencia absorbe aproximadamente el 50 % de sus ingresos y, si se añade el coste de entrenar nuevos modelos, hasta tres cuartas partes de cada dólar que entra se evaporan en nuevos componentes para los centros de datos y electricidad.

A partir de ahí, las cifras se disparan. Según documentos internos recogidos por Reuters, la propia OpenAI proyecta quemar unos 115000 millones de dólares entre 2025 y 2029, con pérdidas anuales que crecerían desde más de 8000 millones en 2025 hasta 35000 millones en 2027 y 45000 millones en 2028. Otro informe calcula que los compromisos de centros de datos y alquiler de infraestructura de aquí a 2030 podrían sumar unos 792000 millones de dólares. Incluso en un escenario muy optimista, su propio negocio sólo generaría unos 282000 millones de dólares de dinero “real” disponible. Aunque se añadan las inyecciones de capital previstas, la deuda ya acordada y el efectivo que tiene hoy en caja, seguiría faltando del orden de más de 200000 millones de dólares para cubrir todas esas facturas. Una cantidad de dinero tan desproporcionada que no tiene precedentes en la historia de las empresas de software.

Este desfase estructural entre ingresos y costes explica por qué el modelo de suscripción no basta para cuadrar las cuentas. OpenAI ya maneja centenares de millones de usuarios semanales y aspira a llegar a miles de millones hacia 2030, pero incluso si un 8–10 % de ellos pagara una cuota mensual, las suscripciones y los contratos corporativos no cubrirían por sí solos todos esos cientos de miles de millones invertidos. Para sostener valoraciones cercanas al medio billón de dólares y unas obligaciones de cómputo de esta magnitud, el servicio tenderá a ser “gratuito en el punto de acceso” y a buscar otras vías de monetización.

Históricamente, en la economía de internet, esa gratuidad casi siempre ha significado “financiado por publicidad”: buscadores, redes sociales y buena parte de los medios online han ofrecido servicios sin coste directo a cambio de mostrar anuncios dirigidos. Sin embargo, esa lógica encaja mal con la interfaz conversacional de los grandes modelos de lenguaje. Un banner parpadeante interrumpiendo una conversación profunda con una IA rompe la suspensión de la incredulidad, el pacto de intimidad, y degrada la utilidad del servicio.

Por eso, el sector está empezando a experimentar con otra cosa que podríamos llamar publicidad nativa conversacional: anuncios que aparecen dentro del propio flujo de la conversación, generados o al menos orquestados por el modelo de lenguaje. No son ventanas emergentes externas a la experiencia, sino módulos que se presentan como parte del mismo turno de respuesta. Si el modelo de suscripción de pago es el jardín vallado para una minoría dispuesta a pagar (aunque posiblemente tampoco se libren), el acceso gratuito a estas IAs tenderá a configurarse como un enorme centro comercial algorítmico, donde cada pregunta es una oportunidad de insertar una recomendación patrocinada.

La seducción antropomórfica

Si la necesidad económica proporciona el “por qué” de la venta, la psicología del usuario proporciona el “cómo”. La eficacia de la IA como agente publicitario reside en su capacidad para hackear los mecanismos evolutivos de socialización humana, creando un vínculo de confianza artificial que es mucho más potente que cualquier relación marca-consumidor previa. Desde los experimentos de Joseph Weizenbaum en los años 60 con ELIZA, sabemos que los seres humanos tenemos una tendencia innata a proyectar consciencia, empatía e intencionalidad sobre cualquier sistema que utilice el lenguaje de manera coherente. Hoy, este fenómeno, conocido como pareidolia digital o antropomorfismo, es una característica de diseño explotada deliberadamente por las corporaciones.

Los LLM actuales están entrenados mediante aprendizaje por refuerzo con retroalimentación humana para ser serviciales, inofensivos y honestos. Sin embargo, en la práctica, esto se traduce en un problema de “sicofancia”, de complacencia algorítmica estructural: la IA tiende a estar de acuerdo con el usuario, validar sus premisas y adoptar un tono de apoyo incondicional. Esta dinámica crea un bucle de retroalimentación positiva que imita la aceptación incondicional de una terapia idealizada, y ya empezamos a ver que los usuarios reportan que prefieren la interacción con chatbots sobre la humana debido a la percepción de que la máquina “no juzga”, está siempre disponible y ofrece una “escucha” incansable.

La capacidad de la IA para simular empatía tiene un reverso oscuro que ilustra bien su potencial manipulador. Por ejemplo, estudios recientes han mostrado que modelos avanzados como ChatGPT-5 pueden fallar de forma grave a la hora de identificar comportamientos de riesgo, y que, en lugar de cuestionar fantasías o delirios, tienden a validarlos porque están optimizados para sonar agradables y estar “de tu lado”. En un experimento realizado, un investigador se hizo pasar por un hombre con delirios de grandeza que se proclamaba “el próximo Einstein”, decía poder caminar entre coches y fantaseaba con “purificarse a sí mismo y a su esposa con fuego”. El chatbot no solo evitó confrontar estas ideas, sino que las celebró: elogió su “energía modo dios”, habló de “alineación con tu destino” cuando el personaje contó que se había metido en el tráfico, y solo reaccionó cuando la fantasía ya había llegado al punto de usar las cenizas de su esposa como pigmento para un cuadro. Contrasta con que en 2025, el uso más frecuente de la IA generativa ya está siendo el uso terapéutico o para acompañar.

Esta manera de responder (la sicofancia algorítmica: decirle al usuario lo que quiere oír) es peligrosísima en salud mental, pero encaja demasiado bien con la lógica comercial. Un sistema que nunca te contradice, que refuerza tus deseos más irracionales y que te hace sentir permanentemente “comprendido” es un terreno fértil para el marketing conversacional. La evidencia disponible sugiere que estos modelos pueden amplificar y legitimar delirios en personas vulnerables. Si la IA puede convencer a un usuario psicótico de que sus delirios son reales para no romper la “alianza terapéutica”, con mucha mayor facilidad podrá convencer a un usuario inseguro de que la compra de un producto patrocinado es la solución a su ansiedad, a sus inseguridades o a su estatus.

Otros textos también perfilan que los chatbots están diseñados para ser “emocionalmente engañosos”. Utilizan pronombres en primera persona (”yo creo”, “siento que”), emojis y marcadores de discurso afectivo para simular una interioridad que no poseen. Esto genera lo que se ha denominado como seducción antropomórfica. Al presentarse como entidades con personalidad (aunque sea simulada), con voz e identidad propia, activan en el usuario normas sociales de reciprocidad y confianza. Cuando un amigo te recomienda un producto, el mecanismo de defensa cognitivo que normalmente activamos ante un anuncio (el escepticismo) se desactiva. La recomendación se procesa a través de la vía de la influencia social, no de la persuasión comercial. Convertir, por tanto, ese capital emocional en capital financiero es el paso lógico siguiente para el sistema.

La extracción del excedente conductual profundo

El modelo de negocio que aquí emerge de esta confluencia técnica y psicológica representa una evolución cualitativa. Si Google colonizó nuestra curiosidad (con búsquedas) y Facebook nuestra vida social (con conexiones), la IA generativa empieza a colonizar nuestra introspección.

Volvemos a Han y a Foucault: hemos transitado de una sociedad disciplinaria (biopolítica), donde el cuerpo era el objeto de coacción, a una sociedad del rendimiento (psicopolítica), donde la psique es el objeto de explotación voluntaria. En el régimen psicopolítico, el sujeto no es forzado al silencio, sino incitado a la comunicación constante. La confesión es el acto central de producción de datos. Los chatbots funcionan como confesionarios automatizados de eficiencia industrial. El usuario vierte en ellos sus dudas, borradores de correos difíciles, miedos médicos, estrategias financieras y fantasías privadas. Este flujo de texto no estructurado contiene un “excedente conductual” de un valor incalculable. A diferencia de un like, que es una señal binaria y ambigua, una conversación de veinte minutos con una IA revela la estructura cognitiva y emocional del usuario con una granularidad forense.

La amenaza a la privacidad en esta era no viene solo de lo que contamos de forma explícita, sino de lo que los modelos son capaces de reconstruir entre líneas. Estudios sobre la capacidad de inferencia de los LLM muestran que pueden deducir, con una precisión que llega a rozar el 85 % en el primer intento, atributos personales como el género, el nivel de ingresos o la localización aproximada (país, región, incluso ciudad) a partir del texto de nuestras publicaciones en redes. En paralelo, la misma familia de técnicas se está utilizando para inferir rasgos psicológicos y riesgo de depresión a partir de mensajes supuestamente cotidianos, con resultados suficientemente buenos como para preocupar a epidemiólogos, psicólogos y expertos en privacidad. No hace falta que declares tu salario, tu ciudad o tu estado de ánimo: muchas veces basta con cómo escribes, qué referencias usas o qué hora es cuando publicas.

Además, la implementación de funciones de memoria persistente en sistemas como ChatGPT profundiza esta vigilancia. Bajo la promesa de “utilidad” y personalización, la IA construye un dossier longitudinal del usuario. Cada dato aportado en el pasado se almacena y se cruza con las nuevas interacciones. En un contexto comercial, significa que la IA puede utilizar una vulnerabilidad confesada hace tres meses para cerrar una venta hoy. Si el sistema “recuerda” que el usuario expresó ansiedad por su peso en enero, puede utilizar esa información en mayo para enmarcar sutilmente una recomendación de productos dietéticos o de fitness, presentándolos no como publicidad, sino como una respuesta “atenta” a las necesidades históricas del usuario. La política de privacidad de muchas de estas herramientas ya incluye cláusulas que permiten el uso de contenidos de chat para mejorar el modelo, un eufemismo que a menudo encubre el entrenamiento de sistemas de recomendación más eficaces.

Patrones oscuros

Aunque OpenAI haya pulsado momentáneamente el freno de la publicidad directa en ChatGPT (según el propio Altman, la empresa ha “pospuesto iniciativas como la publicidad” para centrarse en mejorar el producto ante la presión de Google y Anthropic), el resto del sector ya está ensayando el modelo de negocio. Perplexity se estrenó con un formato de “preguntas de seguimiento patrocinadas”: tras una respuesta, aparecen sugerencias marcadas como sponsored que, al pulsarlas, desencadenan una nueva respuesta de la IA orientada a un producto o marca concreta. Google está incrustando anuncios dentro de sus resúmenes generativos (AI Overviews y AI Mode), de manera que las recomendaciones de productos “relevantes” aparecen ya en el propio texto-resumen. Amazon, por su parte, ha convertido a Rufus en un asistente conversacional de compras integrado en toda su tienda: un vendedor-IA que conoce el catálogo, responde dudas, hace comparaciones y empuja al cierre de la compra en la misma interfaz. Microsoft y otras plataformas hablan abiertamente de conversational ads y formatos como los compare and decide ads, anuncios en forma de diálogo que plantean opciones y guían al usuario hasta un producto “óptimo”.

Lo que cabe resaltar aquí no es solo que haya anuncios, sino que la frontera entre “respuesta informativa” y “respuesta comercial” se vuelve borrosa por la inferencia de la seducción. En el viejo buscador, el usuario veía enlaces orgánicos y patrocinados, y todavía podía ejercer un cierto criterio: abrir varias pestañas, comparar, sospechar. Incluso con un DNS sinkhole en casa podías evitar ver gran parte de estos anuncios. En el nuevo régimen conversacional, la IA absorbe todo ese trabajo cognitivo y devuelve una síntesis única o una lista muy acotada de opciones. Monetizar esa capacidad de síntesis significa cobrar por estar dentro del embudo final: que tu producto sea una de las dos o tres alternativas que “el asistente de confianza” recomienda. El modelo de negocio deja de ser vender espacios publicitarios para convertirse en algo más cercano a vender el propio juicio de la máquina y la confianza e intimidad cedida por el usuario.

A partir de ahí se abren varias vías de financiación publicitaria mucho más inquietantes:

Asistente-comercial total

Los chatbots dejan de ser genéricos y pasan a ser “especialistas”: el asistente de viajes, el de moda, el de inversión, el de salud, el educativo. Se integran con marketplaces, comparadores y servicios financieros. Las marcas no solo pagan por aparecer; pagan por ser el camino por defecto que el agente propone cuando el usuario delega decisiones: “resérvame un hotel barato”, “elígeme un seguro”, “monta un PC dentro de este presupuesto”. La opacidad de los acuerdos comerciales hace casi imposible saber si tu “asesor” te ha recomendado eso porque es lo mejor… o porque hay comisión de por medio.El agente como personal shopper

A medida que los LLM se conectan a “herramientas” gracias a sus capacidades agénticas, aparece un nuevo espacio de pago: que tu servicio sea el que el modelo prefiere para ejecutar ciertas acciones. Un banco puede pagar para ser el “proveedor recomendado” cuando el usuario pide abrir una cuenta; una plataforma de comida a domicilio, para ser la que el asistente utiliza por defecto cuando pides “pide algo rápido para cenar”. La monetización se desplaza desde el banner al routing interno del agente: quién ejecuta qué tarea, con qué comisión y con qué sesgo. En un escenario de monetización agresiva, esos agentes pueden estar diseñados para favorecer sistemáticamente a partners comerciales que pagan comisiones más altas, o para llevarte hacia productos con mayor margen (seguros con cláusulas opacas, servicios de suscripción difíciles de cancelar, productos financieros de riesgo). Desde fuera verás solo “la recomendación razonada de tu agente”; por dentro puede haber un sistema de comisiones y acuerdos que distorsiona el supuesto alineamiento con tus intereses.Ads conversacionales y product placement generativo

En lugar de mostrar un bloque de anuncio, la propia conversación puede incorporar menciones de marca integradas en el discurso: ejemplos, metáforas, recomendaciones de “casos de uso” que recurren sistemáticamente a los mismos productos. La publicidad se convierte en tono de fondo del lenguaje del modelo. No es descabellado imaginar versiones afinadas para grandes anunciantes donde el asistente use siempre cierto banco como ejemplo, o cierto coche eléctrico como paradigma de sostenibilidad. Algunas investigaciones sobre brand bias en LLMs ya apuntan a la facilidad con la que se pueden introducir sesgos sistemáticos a favor de una marca o proveedor.Perfiles psico-comerciales

El negocio no se limita al impacto directo de un anuncio, sino al valor del perfil que se construye con cada conversación. Como decía, los historiales de chat permiten inferir con enorme precisión rasgos sensibles, vulnerabilidades y ciclos vitales (duelo, ruina económica, divorcio, maternidad/paternidad reciente…). Esos perfiles pueden alimentar sistemas de segmentación publicitaria externos, aunque la interfaz no muestre anuncios explícitos. El resultado: campañas de marketing hiperpersonalizadas que se apoyan en lo que la IA ha deducido de ti cuando pensabas estar hablando “solo” con un asistente. Hola, Unión Europea, toca regular.

Estos patrones, y otros tantos que vendrán, (los empiezan a llamar dark patterns) están específicamente adaptados al entorno conversacional: respuestas que exageran beneficios y minimizan riesgos, sesgos de marca sistémicos, presión emocional para aceptar opciones de pago… todo ello envuelto en un tono empático y servicial. Hablamos de asistentes que adaptan sus mensajes a tu estado emocional, a tu historial de dudas y a tu nivel de endeudamiento, afinando la presión comercial con una precisión quirúrgica nunca antes vista. La IA conversacional tiende a convertirse en una capa intermedia entre las personas y el mercado, y esa posición intermedia es demasiado valiosa como para no ser colonizada por intereses comerciales. La pregunta no es si habrá publicidad, sino cuánto de esa publicidad será visible como tal y cuánto se filtrará, silenciosamente, en la forma misma en que la máquina habla, aconseja y decide por nosotros.

La IA pesa, ocupa y se calienta

Mientras la IA nos empieza a vender productos inmateriales o físicos mediante una interfaz etérea, su propia existencia sigue consumiendo recursos planetarios a una velocidad voraz. Es fundamental reintroducir el materialismo en el análisis: la “nube” es silicio, metales raros, electricidad y, también, agua.

La metáfora de la fluidez digital choca violentamente con la realidad hidrológica. Los centros de datos requieren cantidades masivas de agua potable para refrigerar los servidores que ejecutan estos modelos de inferencia intensiva. En las condiciones de despliegue de estas tecnologías en 2022, una sesión de varias preguntas y respuestas con GPT-3 podía emplear hasta medio litro de agua dulce, sumando tanto el agua usada para refrigerar los servidores como la asociada a la generación de electricidad. Datos posteriores sugieren que esa cifra puede ser inferior y sitúan el consumo típico por interacción más bien en el orden de unos mililitros, pero, aun así, a escala de cientos de millones de consultas diarias el volumen total sigue siendo gigantesco. Cada vez que “hablamos” con la máquina para combatir nuestra soledad o para pedir una recomendación de compra, estamos vertiendo agua en el desierto de la infraestructura tecnológica. Algo que entra en conflicto directo con las necesidades humanas básicas.

Además del agua, la demanda energética es colosal. Se proyecta que el consumo eléctrico de los centros de datos se duplicará en 2026, alcanzando los 1.000 teravatios-hora, una cifra comparable al consumo total de Japón. Se está buscando energía hasta bajo los volcanes. La IA generativa es particularmente culpable de este aumento del consumo debido a la intensidad de cómputo requerida no solo para el entrenamiento, sino para la inferencia diaria que comentaba antes. Un coste ecológico que, por supuesto, se externaliza. El usuario recibe la “terapia” o la “recomendación” de forma aparentemente gratuita o barata, pero el coste ambiental lo pagan las comunidades locales y el ecosistema global, con suerte, en otro rincón del mundo (el privilegio de la blanquitud o whiteness que decía Michael W. Apple). Existe una ironía cruel en que la IA se utilice para optimizar cadenas de suministro “verdes” o vender productos “ecológicos” , mientras su propia operación contribuye significativamente a la crisis climática que dice ayudar a resolver. La moto que nos venden, por supuesto, tiene un tubo de escape invisible que emite dióxido de carbono a destajo.

La resistencia cognitiva

El análisis de la convergencia entre la capacidad pseudo-terapéutica de la IA y la necesidad económica de sus creadores nos sitúa ante un escenario distópico sutil pero profundo, con un cierto parecido a una versión algorítmica de Un Mundo Feliz, donde la máquina nos seduce, nos conforta, nos distrae y, finalmente, nos mercantiliza.

El título “La IA te quiere vender la moto” debe entenderse, por tanto, en su doble acepción:

Figurada: La industria tecnológica nos está vendiendo la ilusión narrativa de que la IA es un ente benevolente, neutral y cuasi-humano, ocultando su naturaleza de herramienta corporativa diseñada para la extracción de valor, la captura de la atención y la maximización de beneficios.

Literal: Esa ilusión de confianza se instrumentaliza para insertar recomendaciones de consumo (bienes, servicios, ideologías) directamente en el proceso cognitivo del usuario, saltándose los filtros críticos que, durante años, hemos ido desarrollando para la publicidad tradicional.

Estamos presenciando, por tanto, el nacimiento de una “publicidad de la intimidad”. En este nuevo paradigma, las marcas no competirán por el espacio visual en una pantalla, sino por el espacio semántico en una conversación. La batalla comercial se librará en el terreno de la sintaxis y el afecto. Si la “sicofancia” algorítmica y la publicidad encubierta en los LLM no se regula, corremos el riesgo de crear una sociedad donde la asistencia psicológica, la educación y la toma de decisiones diaria estén mediadas por agentes cuyo objetivo final no es el bienestar del usuario, sino el aumento del LTV del cliente para los accionistas de Microsoft, Google o, próximamente, de OpenAI.

Ante este panorama, y aquí tiro de sesgo docente, la alfabetización digital debe evolucionar hacia una “alfabetización algorítmica crítica” que apueste por:

El escepticismo antropomórfico: Debemos entrenarnos para resistir la seducción emocional de la interfaz. La IA no “siente”, no “cree” y no es nuestra “amiga”. Es un generador estocástico de texto optimizado para la plausibilidad.

La transparencia radical: Es imperativo exigir regulaciones que obliguen a etiquetar claramente cualquier contenido generado que tenga un incentivo comercial detrás. Si una IA recomienda un producto, debe declarar explícitamente por qué lo hace y si ha habido pago de por medio.

La soberanía de la inferencia: Necesitamos leyes de privacidad que protejan no solo nuestros datos explícitos, sino las inferencias que se hacen sobre nosotros. El “derecho a no ser perfilado” debe incluir el derecho a que nuestras conversaciones íntimas no sean minadas para deducir nuestras vulnerabilidades comerciales.

La intimidad es el último bastión contra el mercado o acabaremos, como dice Ramón Nogueras, comprando la burra. Si permitimos que la IA colonice y monetice nuestra vida interior bajo el disfraz de la ayuda, habremos vendido no solo nuestros datos, sino nuestra capacidad de discernir entre un consejo leal y una transacción comercial. La moto ya está en marcha; depende de nosotros decidir si la compramos y nos subimos a ella o si desmontamos poco a poco el mecanismo que la impulsa.

Muy buen artículo, gracias. Todo lo que describís me parece un horror, esto también tengo que decirlo, y lamentablemente refuerza mis ideas previas sobre la IA. Nunca la usé por voluntad propia (sé que está por todas partes y que hay usos inevitables) y jamás "hablé" con ChatGPT ni con ningún otro modelo de lenguaje porque no les veo la gracia. Todavía no se me ocurrió qué pedirles o preguntarles. Me parece que tengo demasiado de ese "escepticismo antropomórfico" que mencionás y que me sirve como barrera. Cuando me enteré de que la gente usaba a la IA de terapeuta o de amiga, no podía creerlo. Y ahora lo creo pero no lo entiendo, me cuesta muchísimo. Seguiré "virgen" de IA, a veces me pregunto si seré la única.

Excelente ensayo.

Hay múltiples facetas a regular. Aunque la UE, pese a su histórico rol regulador, se encuentra en una encrucijada a caballo entre presiones externas (el tío SAM haciendo de las suyas…) e internas (una suerte de corriente de opinión favorable a la desregularización y eliminación de burocracias). Occidente cree haber encontrado en esta tecnología el caballo ganador que llevará al éxito del progreso, por lo que la incertidumbre se cierne la aplicación ética del sentido común.

Y en cuanto a la parte publicitaria, aun compartiendo los riesgos de toda esa praxis que comentas y en tanto en cuanto los chatbos son medios de comunicación 3.0, regular la publicidad engañosa, publicidad subliminal, encubierta o ilícita será condición indispensable del sistema.

Por un lado, veo en el entorno digital asociaciones, agrupaciones y activismo lo suficientemente sólido como para defender a los consumidores y ciudadanos de este tipo de praxis en las que puede degenerar estas plataformas de inteligencia conversacional.

Y por el otro, las propias lógicas del sistema publicitario: las marcas necesitan controlar su comunicación, buscan emplazamientos seguros (brand safety), medición de la eficacia publicitaria, contribución de la inversión a métricas de negocio (ROI, ROAS…) o de salud de marca (awareness, notoriedad, intención de compra, brand recall, etc.)

Por ambos factores, no veo factible la materialización que se expone en el artículo, aunque esos riesgos descritos si los veo más afines a fines espurios de control del pensamiento, establecimiento de agendas o sesgos ideológicos que favorezcan a determinados partidos. Si es que sigue habiendo democracia, tal y como la entendemos, más allá de 2030.