Este TFG lo ha hecho la IA

Anatomía de un Trabajo Fin de Grado generado con ChatGPT y Gemini en una tarde

La universidad contemporánea, esa institución que heredamos y que hemos ido remendando con burocracia, reformas de mercado y una digitalización a menudo epidérmica, se enfrenta hoy a un espejo que no devuelve siempre el reflejo que deseamos. Durante las últimas décadas, bajo el paraguas del Plan Bolonia y la búsqueda de la “competencia”, hemos construido una academia básicamente evaluativa, basada sobre todo en la producción de textos: trabajos finales, ensayos, memorias de prácticas, portafolios y, como culminación de la etapa de grado, el TFG o Trabajo de Fin de Grado. Este último, entronizado como la prueba definitiva de madurez académica, se ha convertido en el escenario de una batalla silenciosa y asimétrica entre la certificación y el aprendizaje, entre el “hacer ver” y el “saber hacer”.

La irrupción masiva de la Inteligencia Artificial Generativa ha acelerado, sobre todo en estos TFG, la obsolescencia de un modelo de evaluación que ya mostraba grietas profundas por la masificación y la mercantilización. Nos encontramos ante lo que podríamos denominar una “ficción de la evaluación” o un “pacto de mediocridad”: nosotros, los y las docentes, a veces fingimos que leemos con profundidad trabajos que ellos, los y las estudiantes, a veces fingen escribir con esmero y esfuerzo.

Este texto que sigue no es, como tampoco fue en semanas anteriores, un lamento ludita contra la tecnología ni un ejercicio de nostalgia elitista por una universidad que nunca fue. Solo intenta diseccionar un cadáver exquisito muy concreto: el TFG tradicional en su formato escrito y burocratizado. En los próximos párrafos exploraré cómo el uso masivo de la IA por parte del estudiantado está desmantelando la concepción básica de la autoría, el esfuerzo intelectual y la propia evaluación. Y para ello, voy a intentar narrar un experimento en primera persona, donde, asumiendo el rol de un estudiante desmotivado pero tecnológicamente competente, elaboro un TFG completo en una de las modalidades que se aceptan en la facultad donde trabajo. En una tarde. Un trabajo que, además, supera las herramientas de verificación de plagio (Turnitin) y que considero que sería capaz, con un poco de chapa y pintura, de obtener un aprobado sin mucho problema según las rúbricas de evaluación vigentes.

Aquí surgen algunas preguntas: ¿Qué perdemos cuando delegamos la escritura a la máquina? ¿Qué dejamos por el camino cuando evitamos la fricción intelectual? Daré respuesta a esto y propondré posibles salidas, sobre todo pensando en la elaboración de los futuros planes de estudios de las Facultades de Educación de toda España, donde el TFG, al menos tal y como lo conocemos, tendrá (posiblemente) difícil encaje en el contexto tecnoeducativo de los próximos años.

Un puñado de datos: la Universidad ante el tsunami generativo

Para entender la magnitud del seísmo pedagógico que ha provocado la irrupción de la IA podemos mirar un poco los datos que se van conociendo. Unas cifras que nos dicen que la adopción es sistémica, generacional y transversal, y que afecta a todas las ramas del saber, ya sean carreras de Humanidades, de Ciencias, Tecnológicas o Artísticas. Según estos datos, el 65% de los estudiantes en España afirma utilizar herramientas de IA en su vida diaria, y un abrumador 90% de los universitarios admite haber usado al menos una herramienta de IA. Más revelador aún es el desglose cualitativo de este uso. No se trata solo de corrección ortográfica. El 49% de los estudiantes utiliza la IA específicamente para redactar ensayos o trabajos académicos. El 63% emplea asistentes virtuales para estructurar sus trabajos, y un 80% la utiliza para buscar información, desplazando a los motores de búsqueda tradicionales y a las bases de datos bibliotecarias. El elefante hace ya tiempo que no cabe en la habitación. Y estos datos son de mayo, el porcentaje es hoy seguro mayor.

Hasta la propia CRUE corrobora esta tendencia, señalando una brecha digital inversa: el uso entre los estudiantes es mucho más extensivo y sofisticado que entre el profesorado o la propia institución universitaria. Mientras las universidades debaten en comisiones éticas y redactan normativas de integridad que a menudo nacen obsoletas, los estudiantes ya han integrado estas herramientas en su flujo de trabajo diario. Un 44% de los estudiantes usa la IA varias veces a la semana y un 35% a diario. La herramienta dejó de ser una curiosidad; es el andamiaje invisible de toda o casi toda su producción académica.

La reacción inicial de muchas universidades hace unos años (meses si van con algo de retraso) fue ponerse a la defensiva: miedo al plagio, más control y una fe casi ciega en los fallidos detectores de IA. Pero la investigación reciente apunta a que esa guerra está perdida y, además, mal planteada. Aunque los detectores han mejorado, la IA avanza más rápido que estos y el alumnado aprende pronto a “humanizar” los textos con mejores prompts, herramientas de parafraseo o simplemente editando a mano lo más robótico o encorsetado, de modo que la detección se vuelve poco fiable y los falsos positivos plantean un problema ético serio: no puedes acusar de fraude a alguien honesto solo porque un algoritmo opaco y sin pruebas lo diga. ¿Sabían que Jane Austen escribió Orgullo y Prejuicio usando una IA?

Al mismo tiempo, el viejo concepto de “integridad académica” se resquebraja ante esta escritura híbrida: ¿es hacer trampa usar una IA para revisar la gramática, para generar ideas, para escribir un párrafo inicial o para resumir un artículo que no se ha leído entero? La frontera se ha vuelto borrosa y, la IA se presenta como un arma de doble filo: puede tanto democratizar el apoyo académico como alimentar nuevas formas de deshonestidad académica industrializada.

¿Por qué hemos llegado a esta disyuntiva? La respuesta fácil podría culpar a la “ley del mínimo esfuerzo”, pero los datos dibujan algo más incómodo: eficiencia, presión por rendir y ansiedad ante la aceleración de los tiempos. Según los datos del informe que citaba antes, un 68% del alumnado cree que la IA le ayuda a ahorrar tiempo y un 43% dice que le permite entender mejor temas complejos que los manuales o incluso que algunos profesores, así que hay cierta sensación de utilidad pedagógica que, los que somos docentes, no podemos ignorar. Sobre todo cuando observamos la utilidad real de herramientas como NotebookLM para guiar, planificar y adaptar el estudio1. Al mismo tiempo, aparece la contraparte: un 39% piensa que la IA puede aumentar las desigualdades y un 72% pide formación específica para utilizarla con criterio y conocimiento. No es tanto querer hacer trampas como intentar sobrevivir en un sistema que les exige producir texto sin parar (trabajos, ensayos, actividades, TFGs), en ocasiones al margen de un aprendizaje profundo y duradero. En esa especie de cadena de montaje académica, la IA se convierte en la herramienta perfecta para entregar el “producto” que se espera, maximizando resultados y minimizando tiempo.

Experimento: Anatomía de un TFG sintético

Dejémonos de datos, de teorías y vayamos directamente al asunto. Como docente que evalúa un buen puñado de TFGs al año, me conozco bastante bien las rúbricas, las estructuras canónicas y esos lugares comunes que, sin necesidad de demostrar verdadera brillantez, suelen bastar en un TFG para contentar a tutores y tribunales. Con esa familiaridad (y con una pizca de mala conciencia profesional), me propuse un reto: un pequeño experimento de empatía radical con el estudiantado. Cogí el manual de elaboración del TFG de mi facultad e intenté hacer, en el menor tiempo posible, un TFG como se supone que deberían podrían hacerlo ellos y ellas para poder cerrar el grado. El manual lo deja claro: hablamos de un trabajo original de unas 6000 palabras y con tipologías relativamente acotadas. Puedes optar, entre otros tipos, por un trabajo de investigación, una revisión bibliográfica, un proyecto de intervención o, como lo que traigo hoy, un trabajo de naturaleza didáctica. En mi caso, siguiendo la LOMLOE (la legislación educativa vigente), una situación de aprendizaje.

La gracia del experimento no está en el “qué”, sino en el “cómo”. Podría haberlo hecho por secciones, como recomiendan los catecismos contemporáneos de la IA: preguntar, repreguntar, afinar, reformular, iterar hasta que el texto parezca escrito por alguien con pulso y con dudas. Pero decidí saltarme esa liturgia y hacer justo lo contrario: ir a lo bruto, directo al producto final.

Para generar un documento de una extensión comparable a lo que se exige, intenté conversar lo menos posible con la máquina. Me impuse dos reglas simples. Primera: tocar lo mínimo los inputs y los outputs, sin obsesionarme con “humanizar” cada frase ni con lijar cada arista para que parezca que aquí no ha pasado nada. Segunda: construir el TFG con el menor número posible de peticiones a la máquina, con intervención humana mínima. En otras palabras: comprobar hasta qué punto se puede “sacar adelante” un TFG casi en piloto automático, siguiendo el manual al pie de la letra y dejando que la IA se coma el grueso del trabajo sucio.

Hay quien diría (los pseudoexpertos en IA) que lo importante, hoy, es saber escribir un buen prompt: explicarle bien a la máquina qué debe hacer, en qué orden, con qué tono y con qué límites. Puede ser. Pero la IA, a veces, se conoce mejor a sí misma que nosotros; y yo, instalado en un modo de pereza cuasi-experimental, llevé la lógica de la flojera hasta el final: arranqué pidiéndole a “la chati” (así la llamo cariñosamente) que redactara el prompt inicial. Un prompt para pedir un prompt. El meta-prompt. El acabose.

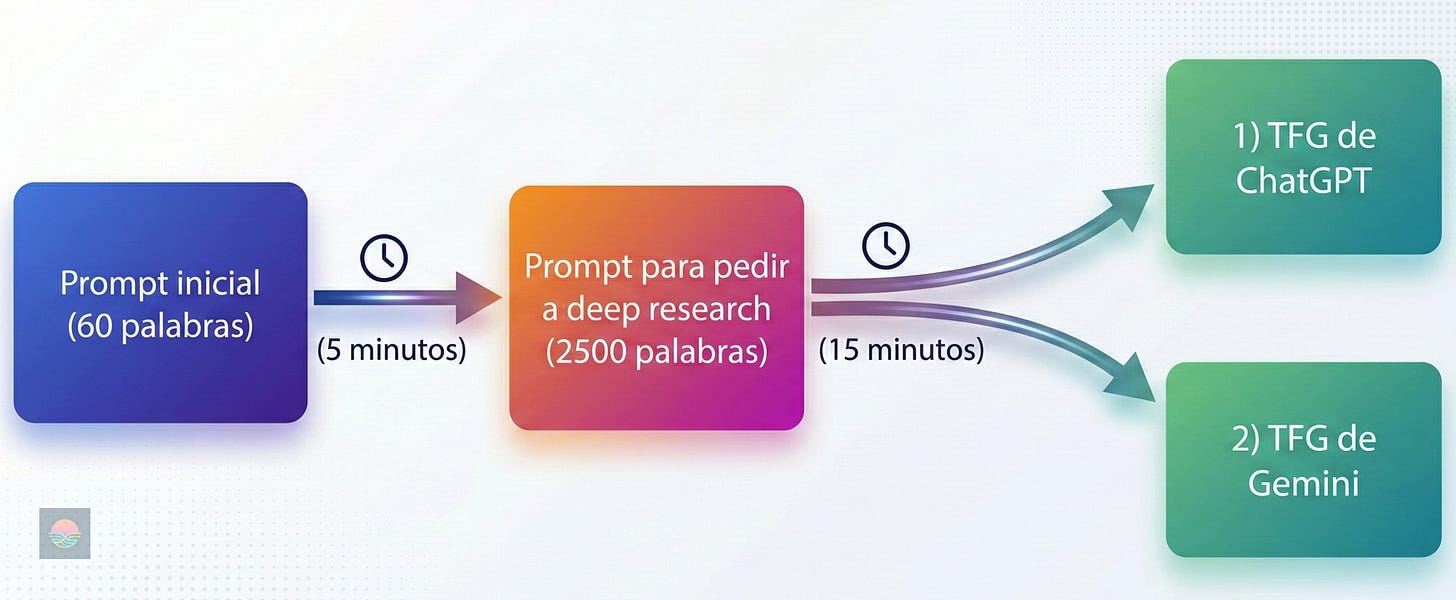

Rol: eres un experto elaborador de prompts para deep research. Acción: Lee este manual que adjunto y elabora un prompt para después solicitar un TFG que se acoja a la modalidad “situación de aprendizaje”. Hazlo para 6º de Primaria. Busca un tema que sea relativamente actual o de relevancia. Sigue todas las instrucciones del manual para esta tipología de trabajos.

Sesenta palabras. Ese fue mi primer contacto con ChatGPT para esta prueba. Sesenta palabras para pedirle algo muy concreto: que leyera un documento (el manual de elaboración del TFG) y que, a partir de ahí, me devolviera una estructura de prompt. Un prompt-puente, por así decir: la plantilla con la que después haría una segunda interacción, ya en modo “investigación en profundidad”, para que la máquina redactara el documento de una sentada, del tirón.

Introduzco esas sesenta palabras en ChatGPT 5.1 Thinking (modelo que ya ha quedado atrás con la reciente salida de 5.2) y, tras un par de minutos leyendo el manual, razonando y rastreando en la red, lo que devuelve es esto: casi 2500 palabras de prompt que dejan milimétricamente definido qué debe hacer la IA en una interacción posterior. Si os fijáis en el documento que enlazo, el prompt lo acota todo (o casi todo). Define el rol de quien escribe (experto en didáctica, normativa y diseño curricular); fija la tarea (un borrador completo de TFG, limitado a 6000 palabras, que respete punto por punto la estructura exigida por el manual); determina el estilo (tono académico, coherencia y cohesión, referencias bibliográficas); y, además, impone límites de extensión tanto para el conjunto como para cada sección. Solo le añado manualmente lo que aparece resaltado en verde, por si sirve de algo: “Escritura propia de un estudiante de Grado, de unos 22 años, con algunos errores propios de la edad. Nivel aproximado: notable en su expediente académico.” y “Humaniza la escritura para que no se note que está escrito por IA”.

A partir de ahí, el prompt afina el contexto académico del trabajo: concreta la tipología elegida, selecciona un tema y lo ajusta al nivel solicitado (desinformación y fake news en redes sociales, para 6.º de Primaria), encuadra el marco curricular en Andalucía y desglosa con bastante precisión cada apartado obligatorio del TFG (Introducción, Justificación, Finalidad, Metodología, Secuenciación didáctica, Evaluación, Atención a la Diversidad, Conclusiones y Referencias). Incluso incluye el lugar de los anexos, anticipa qué decir sobre el “uso de IA” en el propio trabajo y remata, como quien cierra un contrato, reiterando el formato de salida que debe tener el texto final.

“Haciendo” y evaluando el TFG

Tenemos el prompt hiperdetallado, tenemos un par de IAs dispuestas a colaborar, activamos el modo deep research en ambas, pulsamos enter y esperamos alrededor de unos quince minutos. ChatGPT me da esto, Gemini, unos minutos antes, me devuelve esto otro. Queríamos un TFG y ahora tenemos dos. A simple vista ya se ve que no son gemelos: se parecen en el esqueleto, pero difieren en el cuerpo, y sobre todo en la talla. ChatGPT se salta por completo los límites de palabras que venían en el prompt y se lanza a una prosa de más de 20000 palabras: muere por verborrea. Gemini, en cambio, se contiene: se acerca a las 6000 palabras contando referencias (las que cita y las que el propio modelo lista), como si entendiera que un TFG no debe ser la trilogía de El señor de los Anillos. Uno se pasa por mucho; el otro roza el mínimo. Pero la pregunta importante no es aritmética. La pregunta es otra: ¿qué tipo de documentos son estos que aparecen, así, en un cuarto de hora, como si la página en blanco ya no existiera?

El documento que da ChatGPT está lleno de carriles, señalización y barandillas. La estructura es canónica y reconocible (introducción–justificación–finalidad–metodología–secuenciación–evaluación–DUA–conclusiones–referencias), el vocabulario es institucional (“competencias clave”, “perfil de salida”, “situación de aprendizaje”, “rúbrica”, “triangulación”), y la propuesta didáctica se despliega con un nivel de granularidad extensísimo: sesiones, objetivos, actividades, recursos, organización, conexión con la realidad, instrumentos… El texto marca todas las casillas; de hecho, por momentos parece más una programación anual comprimida que un trabajo de fin de grado con tesis, ideas claras y toma concisa de decisiones. Ese es principalmente su problema: la hipercompetencia formal se paga con prosa anestesiada y una lógica de sobreproducción de burócrata eficiente. Todo está, pero casi nada respira autenticidad, inexperiencia, arrojo...

En cuanto rascas un poco, aparece lo más revelador desde una óptica humana crítica: el texto finge experiencia para sostener verosimilitud. Habla como si hubiera habido implementación y resultados (“esto de hecho sucedió con algún alumno tímido…”, evidencias anotadas en rúbricas, mejoras observadas, colaboración con otros profesionales que “se asume” que existen), es decir, redacta un campo que no existe o que, como mínimo, no está documentado. Ese desplazamiento (de diseño didáctico a narración de intervención) es una firma típica del texto sintético: rellena el hueco metodológico con escenas plausibles y con un tono de “memoria profesional” que parece honesto, pero que no es verificable. Imaginen lo que hace cuando se le piden datos para un trabajo de investigación. A eso se suma una bibliografía más bien frágil: mucho enlace institucional (BOE, Junta, UNESCO, INCIBE), alguna pieza de divulgación/periodismo, y algún apoyo académico puntual; suficiente para sonar “fundamentado”, pero insuficiente para sostener un marco teórico serio y actualizado, sobre todo por el uso de alguna fuente de dudosa calidad.

En resumen: así, tal cual, no es un texto para entregar. Se pasa de largo, se desparrama, canta por exceso y por esa seguridad sin cuerpo que tienen los documentos “perfectamente montados”. Pero ahí está precisamente el punto: con un puñado razonable de horas de maquillaje y peluquería (recortar, reordenar, ajustar el tono, reforzar dos o tres fuentes, meter alguna decisión más personal y borrar lo que suena a plantilla) puede empezar a dar el pego sin demasiada dificultad. Y es que partir de un documento de esta longitud cambia por completo el juego. Aunque sea desigual, hay tramos aprovechables y bien detallados; el trabajo del estudiante deja de ser construir y pasa a ser seleccionar y pulir. No hay búsqueda real, no hay atasco, no hay ese momento de “no sé por dónde empezar” que te obliga a pensar, a decidir y a entender. La fricción de la página en blanco desaparece: ya no escribes, editas. Y editar, incluso cuando exige criterio, no es lo mismo que pensar desde cero.

A diferencia del texto hiperverboso de ChatGPT, el TFG de Gemini se presenta como un producto algo más “entregable”: respeta bastante bien el tamaño, mantiene una estructura académica estándar y avanza con una lógica relativamente limpia (introducción, marco teórico, anclaje normativo LOMLOE/Andalucía, y una SdA bien secuenciada tipo “Detectives de la Verdad”). La prosa es sobria, más contenida, y la propuesta didáctica es plausible en su forma: objetivos, metodología (gamificación, rutinas de pensamiento, cooperativo), sesiones, evaluación, DUA. Es, en el mejor sentido burocrático del término, un documento competente: marca casillas con oficio y ofrece al lector cansado (aquel que tiene que evaluar muchos de estos) la sensación de que “todo está en su sitio”.

Ahora bien, leído con mirada humana crítica, se nota el mismo patrón de fondo: formalidad como sustituto de conocimiento situado. Listados de elementos. La contextualización del centro y del grupo (25 alumnos, tablets en proporción 1:2, diversidad “de manual”: TDAH, altas capacidades, incorporación tardía) parece más una plantilla estadística que un diagnóstico real, y el diseño se apoya en marcos y conceptos correctos pero tratados como pegatinas (Piaget/Vygotsky, DigComp, UNESCO) sin una discusión verdaderamente problematizadora. El aparato de fuentes es también débil: mezcla referencias académicas con materiales secundarios o de baja exigencia (blogs, páginas comerciales, recursos genéricos), lo que delata que no hay una búsqueda rigurosa sino una agregación eficiente.

Y, sin embargo (aquí está lo inquietante), no está tan lejos. Con un poco de chapa y pintura, con un poco de este y otro poco de aquel, puede empezar a parecer “un TFG de verdad”: recortar lo más plantillero, reforzar bibliografía con cuatro o cinco textos sólidos, ajustar la contextualización con detalles verosímiles, y añadir un puñado de decisiones explícitas (por qué este enfoque y no otro, qué riesgos tiene, qué límites asumes). No es un salto cualitativo gigantesco: es básicamente postproducción. El texto, tal cual, deja ver la costura; pero la costura está a una tarde de ocultarse.

Ahí entra el dato que de verdad cambia el tablero: el tiempo. Vale, tenemos dos trabajos, y ninguno sirve para entregar tal cual. Uno se desborda y se pasa de largo; el otro es más contenible, pero huele a plantilla y a bibliografía débil. Pero ha pasado menos de una hora desde que empecé a hablar con las IAs y ya tengo una masa de material que antes requería semanas: estructura completa, redacción “aceptable”, actividades, evaluación, DUA, justificaciones y hasta un esqueleto de referencias. Y recuerden: ni siquiera tuve que detenerme a leerme el manual o a escribir la estructura o los detalles finos en el prompt; eso también lo hizo la máquina.

A partir de aquí el esfuerzo cambia de naturaleza: recortes, injertos y luego seguir iterando con la IA párrafo a párrafo para ir maquillando el tono, metiendo una voz algo más propia, y rellenando huecos donde haga falta. Lo que el plan de estudios imagina como 150 horas de trabajo autónomo (6 ECTS) se convierte, para un estudiante mínimamente hábil, en un par de tardes de selección, edición y puesta en escena. Ya no hay bloqueo ante la página en blanco: hay miles de palabras de material bruto. Y cuando el trabajo deja de ser escribir y pasa a ser editar, la fricción (esa parte lenta y formativa del proceso) puede evaporarse sin hacer ruido.

¿Tiene sentido seguir con esta farsa?

¿Dónde creo que está el problema? En que la evaluación, tal como la hemos estructurado, premia justo lo que mejor hacen las máquinas. Premia el apartamento piloto. La rúbrica (por muy bienintencionada que sea) mide señales visibles: coherencia formal, orden, citas en APA, secciones completas, alineamiento con normativa. Señales que, dicho sin dramatismo, son precisamente las señales que un sistema generativo reproduce con mayor facilidad cuando le das un manual y un objetivo claro. La IA no solo puede producir un texto “aprobable”: puede producir un texto que encaja con el molde mejor que muchos textos humanos, porque no se cansa, no se desmotiva y no odia la sección de “Metodología” a las tres de la mañana de un jueves.

Aquí la pregunta ya no es si el alumnado “hace trampa”. La pregunta es: ¿qué estamos evaluando exactamente cuando evaluamos un TFG escrito como producto final? Si lo que evaluamos es la capacidad de cumplir un formato, de montar un documento que parezca universidad, entonces la IA es una herramienta de optimización. Si lo que evaluamos es la capacidad de pensar, investigar, tomar decisiones, argumentar y sostener una propuesta, entonces el formato actual empieza a fallar por diseño, porque permite separar el texto del proceso.

Como decía antes, los detectores de IA fallan, pero aun suponiendo que funcionaran, seguiríamos en el mismo sitio: haciendo de policía de estilos. Defendiendo un modelo de evaluación que ya venía, antes de la IA, renqueando por masificación, por precariedad de tutorías, por la cadena de montaje de entregas. La IA solo ha puesto una luz blanca sobre algo que ya estaba ahí: que hemos montado una universidad donde producir texto es, muchas veces, sinónimo de aprender. Y ahora el texto puede producirse con una facilidad inquietante, se puede hacer un baipás a eso del aprender.

Entonces, sí: hay una farsa. Pero no conviene localizarla únicamente en el alumnado. La farsa también está en el lado institucional: en sostener que este formato sigue siendo una prueba robusta de algo profundo cuando, en realidad, se ha convertido en un trámite estandarizado, evaluado bajo presión y con herramientas pensadas para un mundo que ya no existe. La cuestión no es si el TFG “desaparece”. La cuestión es si queremos seguir sosteniendo un ritual burocrático que, en el mejor de los casos, evalúa cumplimiento; y, en el peor, evalúa quién tiene más tiempo, más capital cultural, mejores herramientas o más capacidad de simular.

Si la universidad quiere sobrevivir a esta fase sin convertirse en una notaría de PDFs, tiene que mover el eje. No se trata de prohibir la IA como si fuera un vicio (tampoco es que pudieran hacerlo); se trata de rediseñar la evaluación para que la IA no pueda sustituir lo que realmente importa. Hay guías internacionales que insisten en una idea sencilla: una integración humanocéntrica, con formación y con políticas que no sean solo punitivas. Traducido a la práctica del TFG: necesitamos que el producto final deje de ser la única evidencia. Necesitamos proceso, situación y defensa.

Algunas opciones, nada futuristas:

TFG como proceso verificable. No “entrega final” sino itinerario: decisiones justificadas, borradores, bitácora de cambios, búsqueda documental con huella, discusión de elecciones metodológicas, participación en debates académicos, registro de dudas. Menos masificación para poder atender, de verdad, a cada estudiante individualmente. Aquí la IA puede estar, pero debe estar nombrada y situada: qué hizo, qué no hizo, qué se aceptó, qué se rechazó y por qué.

TFG como producto público y defendible. Si el TFG es una situación de aprendizaje, que tenga vida fuera del documento: prototipo, intervención, materiales probados, análisis de implementación, rastros verificables y una defensa oral no memorizada con preguntas no guionizadas. La IA puede ayudar a redactar, pero no puede improvisar una justificación pedagógica si quien ha hecho el trabajo no la entiende.

TFG como portafolio de trayectoria. En Facultades de Educación esto tiene sentido: evidencias acumuladas de prácticas, proyectos innovadores, reflexiones situadas, análisis de casos de aula, y un cierre integrador. Menos “monolitos de 6000 palabras” y más mapas de aprendizaje, donde la IA se integra para fortalecer el aprendizaje, no para saltarse fases completas.

El objetivo no debería ser “pillar las trampas”, sino recuperar algo que hemos ido perdiendo: fricción. No como sufrimiento romántico, sino como condición mínima para que pensar y escribir sean algo más que producir un texto aceptable.

Antes de la IA, había un “emprendedor”

Y aquí conviene recordar algo incómodo que a veces se obvia: antes de ChatGPT ya existía el mercado de la externalización académica. Tanto que hasta tiene nombre en la literatura internacional: contract cheating, essay mills. Empresas o plataformas que, a cambio de dinero, producen trabajos para que el estudiante los entregue como propios.

En España, además, no estamos hablando de un fenómeno fantasmal. Hay trabajos de investigación que han analizado el ecosistema de estas plataformas, su tráfico, su publicidad en buscadores y sus estrategias de captación. El lenguaje comercial es revelador: se presentan como “ayuda”, “asesoría”, “acompañamiento”, y a veces incluso prometen garantías. No venden solo texto: venden alivio. Y esa es la clave: explotan un punto de vulnerabilidad estudiantil que no es solo moral, sino estructural.

La diferencia con la IA no es que ahora exista una herramienta que “haga el trabajo”. Eso ya existía. La diferencia es que ahora esa externalización se vuelve barata, escalable y cotidiana. Ya no necesitas un redactor experto; necesitas una máquina que te devuelva una versión plausible del molde, y luego unas capas de edición para que no huela demasiado a plástico. El nuevo umbral de acceso a la externalización es ridículo (unos 20 euros al mes). La industria del encargo no desaparece: se reconfigura. Se vuelve, como casi todo, una mezcla de automatización y barniz humano donde haga falta.

Las IAs entre maestros, influencers y la burrocratización de la educación

Es necesario abrir un poco el plano, porque esto no va solo de estudiantes. También va de nosotros, los y las docentes. En paralelo a la proliferación de TFGs sintéticos, está emergiendo también el docente sintético: un profesor que delega en la IA buena parte de las tareas burocrático-didácticas que el sistema le exige para poder seguir respirando. Programaciones, adaptaciones, informes, situaciones de aprendizaje, rúbricas, actividades, boletines de evaluación. En Primaria, en Secundaria y también en Educación Superior. IA para todo eso que, en teoría, debería ser pensamiento pedagógico situado, pero que en la práctica se convierte (demasiadas veces) en documentación para cumplir que muchas veces no lee nadie.

Y en ese terreno también ha florecido ya el mercado. Herramientas y plataformas que se presentan como “asistentes de IA para profesores”, prometiendo ahorrar horas semanales generando clases, pruebas, materiales… en minutos. Teachy, Megaprofe, Kumubox, Sennia… El mensaje es siempre el mismo, con distintos logos: no pierdas tiempo. Produce. Entrega. Cumple. No se trata solo de ayudarte a enseñar; se trata de ayudarte a tramitar la enseñanza.

También es interesante (y de nuevo, inquietante) el puente con el fenómeno influencer. Hay investigación que describe cómo parte del profesorado, especialmente en redes como Instagram, participa de dinámicas de comercialización: venta de materiales, promoción de productos, construcción de marca personal, y un tipo de pedagogía empaquetada para ser consumida. No es (solo) narcisismo: es supervivencia en un contexto donde el salario no crece, la carga sí, y donde el reconocimiento profesional se desplaza hacia la visibilidad. Aunque esto daría para otro Kiribati.

El resultado es un paisaje raro: docentes públicos convertidos en miniemprendedores que enseñan su aula como escaparate, que recomiendan herramientas y recetas pedagógicas “milagro” y que ahora también venden IA especializada para “hacerte la programación”, “generarte informes”, “adaptarte actividades”... Y es que la promesa de la eficiencia encaja perfectamente con la burrocratización (sí, con doble R) educativa: cuanto más te piden que documentes, más valor tiene una máquina que documenta por ti, sobre todo si, como decía antes, no te van a leer.

Cuando la institución convierte la pedagogía en papeleo inerte, la automatización aparece como salvación. Igual que el estudiante no busca “aprender menos” sino “sobrevivir a la cadena de entregas”, el docente no busca “enseñar peor” sino “sobrevivir a la cadena de documentos e informes”. Y entonces se cierra el circuito: el estudiante usa IA para producir trabajos y el TFG que el sistema espera; el docente usa IA para producir los informes que el sistema exige; y la universidad (y la escuela) se convierten en un intercambio de textos plausibles, cada vez más perfectos, cada vez más vacíos.

Voy cerrando. Quizá el problema no sea que la IA “hace” TFGs, sino que el TFG (tal como lo hemos convertido) estaba ya demasiado cerca de ser hecho por cualquiera que dominara el molde. La IA no inventa la ficción: la vuelve eficiente, barata y escalable. Y esa eficiencia, que en otros ámbitos se celebraría como progreso, aquí actúa como prueba de estrés: si el sistema admite sin demasiada resistencia un texto producido en piloto automático, entonces lo que certificábamos no era tanto aprendizaje como capacidad de cumplir un protocolo. La pregunta, por tanto, no es si prohibimos la herramienta o si perseguimos al estudiante con detectores; la pregunta incómoda es qué parte de nuestra universidad estaba o está diseñada para confundir escritura con pensamiento, producto con proceso, documento con comprensión.

Si el TFG quiere seguir existiendo, tendrá que mutar: menos monumento textual y más trayectoria demostrable; menos PDF y más oralidad, más debate, más práctica defendible. Y ahí, paradójicamente, la IA puede tener un lugar digno: no como coartada para seguir produciendo burocracia, sino como herramienta de aprendizaje, declarada y acotada dentro de un proceso que intenta volver a ser humano porque no hay nada más humano que querer aprender. El resto es seguir levantando diques de papel mientras la marea ya está dentro.

https://www.nature.com/articles/s41539-025-00319-0 (Para los que quieran explorar más sobre IA y su potencial para el Self-Regulated Learning)

Qué bombardeo de reflexiones, qué interesante y a la vez qué abrumado estoy de tantas cuestiones tan bien planteadas. Creo también que ofreces buenas posibles rutas de cambio, pero me es inevitable pensar qué cabida tiene también en el sistema actual de prácticas-TFM del alumnado de Magisterio.

Soy de la generación inmediatamente anterior a las IAs generativas; estoy de acuerdo con que el sistema de TFGs/TFMs ya estaba estructuralmente obsoleto. También de acuerdo con la poca reflexión-adaptación del material al alumnado, de la falta de prueba-error. Pero lo veo muy complicado. Si los docentes de colegios ya estamos ahogados con burocracia, los alumnos/as de prácticas tristemente tienen poca cabida y campo de prácticas, bajo mi punto de vista. Nace de la buena fe de los docentes y para mí eso, ya es un fracaso.

Uf, directo al corazón este post. Me ha hecho pensar en muchas cosas: en lo que valoraba en los trabajos "prácticos" (respuestas "correctas" vs. reflexiones situadas), en lo que me empuja a mí a usar la IA (me identifico mucho con el profesor agobiado por las exigencias burrocráticas), en mi propio desconocimiento de las potencialidades de estas herramientas (jamás se me habría ocurrido usar un meta-prompt)... Y ahora que voy a ser profesor de filosofía en instituto, más todavía: el texto escrito, especialmente el argumentativo, es un fetiche de la disciplina que, sin embargo, corre el riesgo de quedarse totalmente desfasado con estas herramientas. Seguiré dándole vueltas a estas cuestiones en los próximos años.